Bílý dům se setkává se společnostmi AI

Bílý dům se sešel s hlavami sedmi společností, aby podpořili dobrovolné závazky k vývoji bezpečné a transparentní umělé inteligence, ale Apple mezi přítomnými nebyl a není jasné proč.

Administrativa nedávno oznámila, že zajistila dobrovolné závazky sedmi předních společností zabývajících se umělou inteligencí (AI) k řízení rizik, která AI představuje. Tato iniciativa podtrhuje zásady bezpečnosti, zabezpečení a důvěry při vývoji technologií umělé inteligence.

Mezi společnosti, které přislíbily svůj závazek, patří Amazon, Anthropic, Google, Inflection, Meta, Microsoft a OpenAI. Zajímavé je, že navzdory práci Applu v oblasti AI a strojového učení společnost na jednáních chybí.

Nepřítomnost společnosti Apple v této iniciativě vyvolává otázky o postoji společnosti k bezpečnosti AI a jejím odhodlání řídit rizika spojená s technologiemi AI.

Závazky a iniciativy AI

Jedním z hlavních závazků těchto společností je zajistit, aby produkty umělé inteligence prošly přísným interním a externím bezpečnostním testováním, než budou zveřejněny. Cílem testování je chránit před významnými riziky umělé inteligence, jako je biologická bezpečnost, kybernetická bezpečnost a širší společenské dopady.

Kromě toho tyto společnosti převzaly odpovědnost za sdílení důležitých informací o řízení rizik AI. Sdílení těchto informací nebude omezeno na průmysl, ale rozšíří se na vlády, občanskou společnost a akademickou sféru.

Cílem je stanovit osvědčené postupy pro bezpečnost, poskytovat informace o pokusech obejít bezpečnostní opatření a podporovat technickou spolupráci.

Pokud jde o bezpečnost, tyto společnosti výrazně investují do opatření kybernetické bezpečnosti. Významným cílem je ochrana proprietárních a nevydaných vah modelů umělé inteligence, které jsou klíčovými součástmi systému umělé inteligence.

Společnosti se dohodly, že tyto modelové váhy by měly být uvolněny pouze tehdy, když je to zamýšleno a po zvážení potenciálních bezpečnostních rizik. Kromě toho usnadňují zjišťování a hlášení zranitelností v jejich systémech AI třetími stranami, čímž zajišťují, že jakékoli přetrvávající problémy budou okamžitě identifikovány a opraveny.

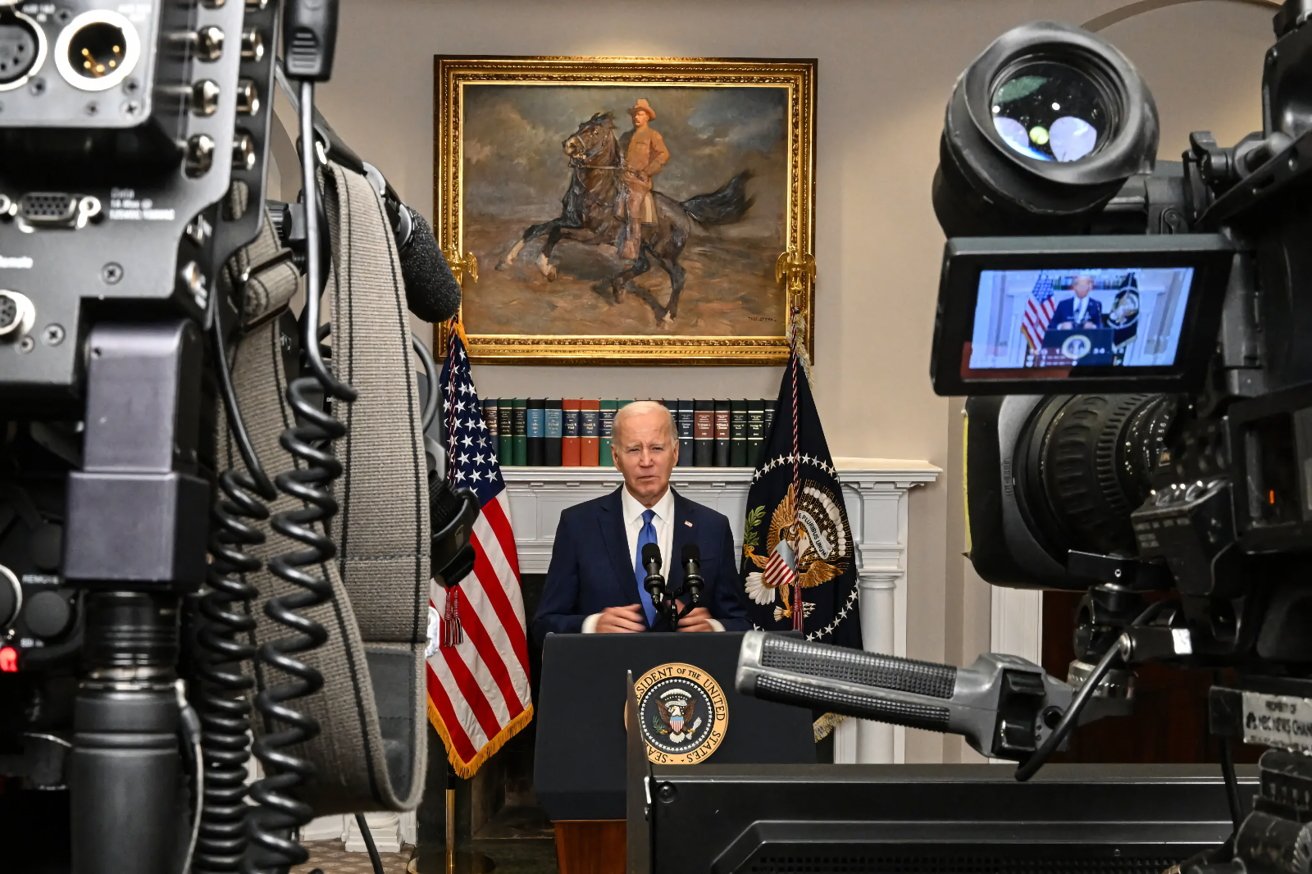

Prezident Biden se setkává se společnostmi AI ohledně bezpečnostních standardů a závazků. Zdroj: Kenny Holston/The New York Times

Aby si tyto společnosti získaly důvěru veřejnosti, vyvíjejí robustní technické mechanismy, které zajistí, že uživatelé budou moci identifikovat obsah generovaný umělou inteligencí, například prostřednictvím systémů vodoznaků. Tento přístup umožňuje kreativitě s umělou inteligencí prosperovat a zároveň minimalizovat rizika podvodu a podvodu.

Kromě toho se tyto společnosti zavázaly veřejně podávat zprávy o svých systémech umělé inteligence, pokrývající bezpečnostní a společenská rizika, aby se zabývaly oblastmi, jako jsou účinky umělé inteligence na spravedlnost a zaujatost.

Výzkum je také významným zaměřením. Společnosti upřednostňují výzkum společenských rizik, která mohou systémy umělé inteligence představovat, což zahrnuje úsilí vyhnout se škodlivé zaujatosti a diskriminaci a chránit soukromí uživatelů.

Jsou také odhodláni využít umělou inteligenci k řešení některých nejnaléhavějších výzev společnosti, od prevence rakoviny až po zmírňování změny klimatu.

Vláda také připravuje exekutivní nařízení a prosazuje legislativu obou stran na podporu odpovědných inovací AI. Konzultovali s mnoha zeměmi, včetně Austrálie, Brazílie, Kanady, Francie, Německa, Indie, Japonska a Spojeného království, aby vytvořili robustní mezinárodní rámec pro vývoj a používání AI.

Zdroj: appleinsider.com