Vyřazený nástroj pro detekci CSAM společnosti Apple

Skupina pro bezpečnost dětí prosadila Apple, proč byla oznámená funkce detekce CSAM opuštěna, a společnost poskytla dosud nejpodrobnější odpověď na to, proč od svých plánů ustoupila.

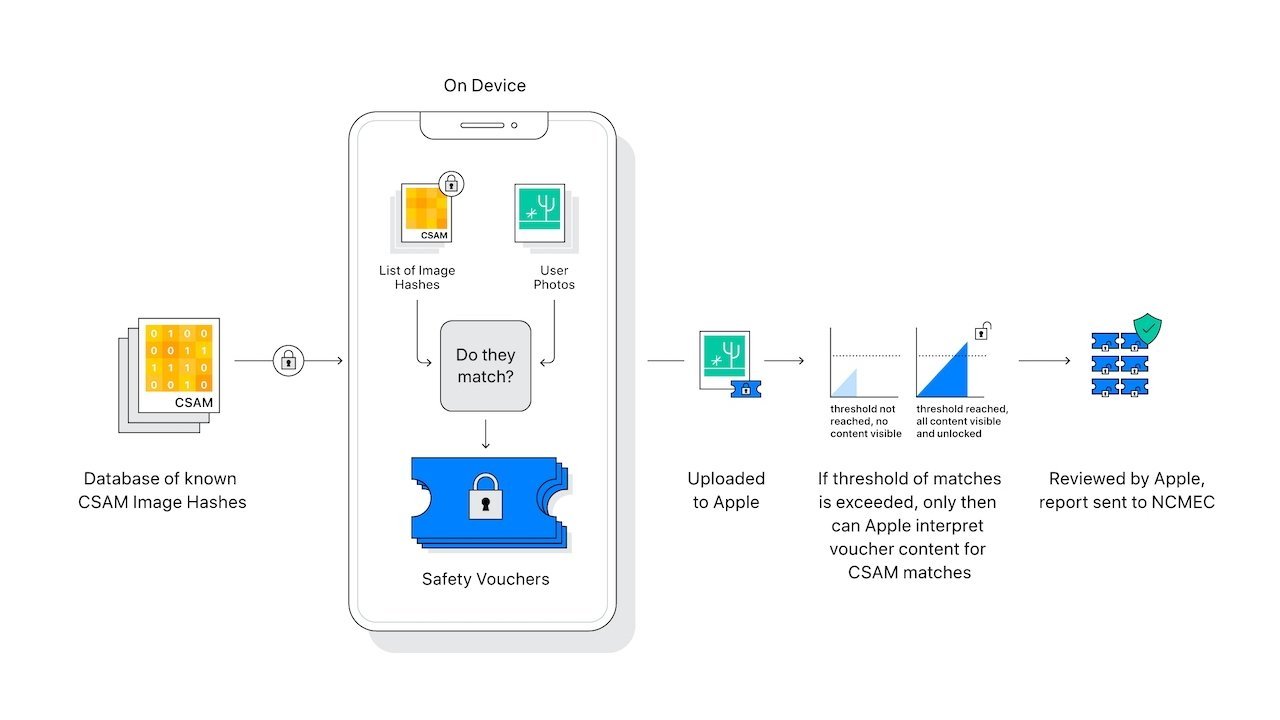

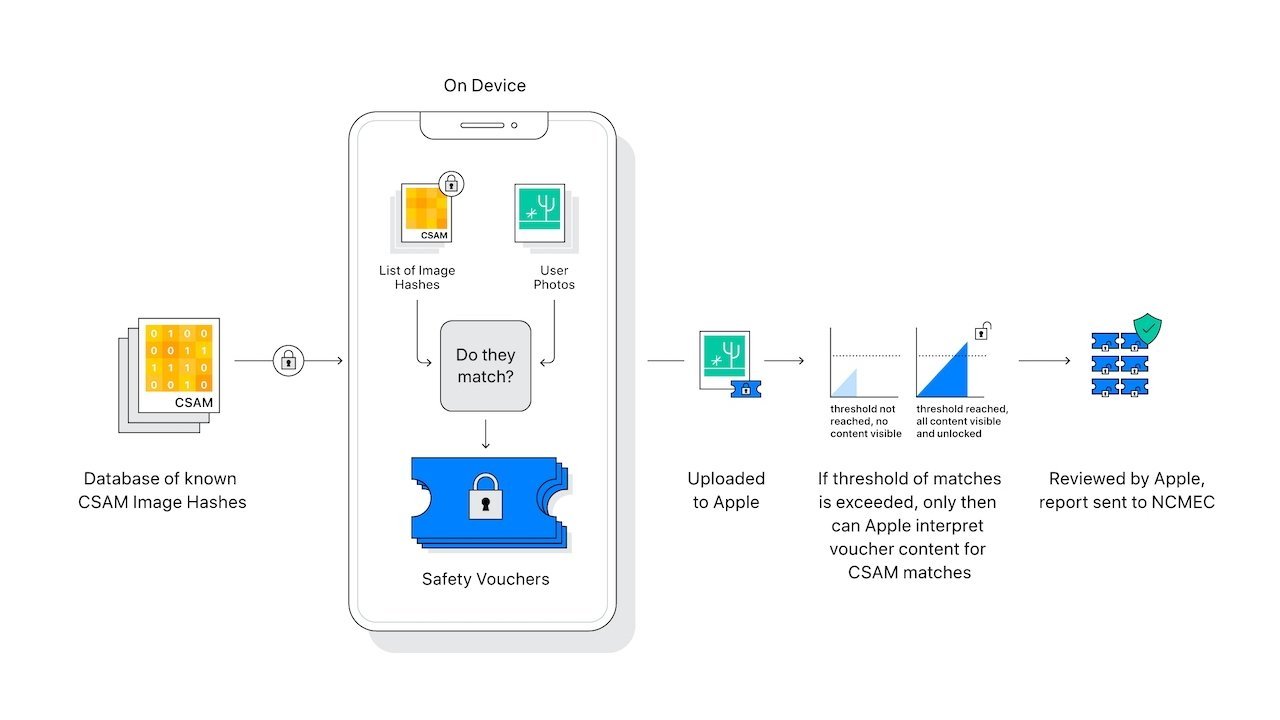

Materiály týkající se sexuálního zneužívání dětí jsou trvalým vážným problémem, který se Apple pokusil řešit pomocí nástrojů pro detekci na zařízení a iCloud. Tyto kontroverzní nástroje byly nakonec opuštěny v prosinci 2022, což vedlo k dalším kontroverzím.

Skupina pro bezpečnost dětí známá jako Heat Initiative sdělila Applu, že zorganizuje kampaň proti rozhodnutí upustit od detekce CSAM v naději, že ji přinutí nabízet takové nástroje. Apple odpověděl podrobně a Kabelové byla zaslána odpověď a její obsah byl podrobně popsán ve zprávě.

Odpověď se zaměřuje na bezpečnost a soukromí spotřebitelů, což je důvodem, proč se Apple zaměřil na sadu funkcí nazvanou Bezpečnost komunikace. Snaha najít způsob, jak získat přístup k informacím, které jsou běžně zašifrované, je v rozporu s širším přístupem společnosti Apple k ochraně soukromí a zabezpečení – což je pozice, která nadále znepokojuje světové mocnosti.

„Materiál týkající se sexuálního zneužívání dětí je ohavný a jsme odhodláni prolomit řetězec nátlaku a vlivu, díky kterému jsou děti náchylné k tomu,“ napsal Erik Neuenschwander, ředitel společnosti Apple pro ochranu soukromí a bezpečnost dětí.

„Skenování soukromě uložených dat na iCloudu každého uživatele by vytvořilo nové vektory hrozeb, které by zloději dat mohli najít a zneužít,“ pokračoval Neuenschwander. „Také by to přineslo potenciál pro kluzký svah nezamýšlených důsledků. Skenování jednoho typu obsahu například otevírá dveře hromadnému sledování a může vyvolat touhu prohledávat jiné systémy šifrovaných zpráv napříč typy obsahu.“

„Rozhodli jsme se nepokračovat v návrhu hybridního přístupu klient-server k detekci CSAM pro iCloud Photos z doby před několika lety,“ dokončil. „Došli jsme k závěru, že to není prakticky možné implementovat, aniž by to v konečném důsledku ohrozilo bezpečnost a soukromí našich uživatelů.“

Neuenschwander reagoval na žádost Sarah Gardner, vedoucí iniciativy Heat Initiative. Gardner se ptal, proč Apple ustoupil od identifikačního programu CSAM na zařízení.

„Pevně věříme, že řešení, které jste představili, nejenže postavilo Apple na pozici globálního lídra v oblasti ochrany soukromí uživatelů, ale také slíbilo, že odstraní miliony obrázků a videí sexuálního zneužívání dětí z iCloudu,“ napsal Gardner. „Jsem součástí rozvíjející se iniciativy zahrnující zainteresované odborníky na bezpečnost dětí a obhájce, kteří mají v úmyslu se s vámi a vaší společností Apple zapojit do vašeho pokračujícího zpoždění při implementaci kritické technologie.“

„Sexuální zneužívání dětí je obtížný problém, o kterém nikdo nechce mluvit, a proto je umlčen a ponechán stranou,“ dodal Gardner. „Jsme tu, abychom zajistili, že se to nestane.“

Namísto přístupu, který by narušil důvěru uživatelů a udělal z Applu prostředníka pro zpracování zpráv, chce společnost pomoci nasměrovat oběti ke zdrojům a donucovacím orgánům. Rozhraní API pro vývojáře, která mohou používat aplikace jako Discord, pomohou vzdělávat uživatele a nasměrovat je, aby nahlásili pachatele.

Apple žádným způsobem „neprohledává“ uživatelské fotografie uložené na zařízení nebo na iCloudu. Funkce Bezpečnost komunikace může být povolena pro dětské účty, ale neupozorní rodiče, když je v chatech zjištěna nahota.

Zdroj: appleinsider.com