Umělá inteligence bere svět útokem, a i když byste mohli používat Google Bard nebo ChatGPT, můžete na svém Macu použít také lokálně hostované. Zde je návod, jak používat novou chatovací aplikaci MLC LLM.

Umělá inteligence (AI) je novou špičkovou hranicí počítačové vědy a vytváří ve světě počítačů poměrně velký humbuk.

Chatboti – Aplikace založené na umělé inteligenci, se kterými mohou uživatelé konverzovat jako experti na doménu, jsou přinejmenším stále oblíbenější.

Chatboti mají zdánlivě odborné znalosti o široké škále obecných a specializovaných témat a jsou všude nasazováni rychlým tempem. Jedna skupina – OpenAI – před několika měsíci vydala ChatGPT do šokovaného světa.

ChatGPT má zdánlivě neomezené znalosti prakticky o jakémkoliv tématu a může odpovídat na otázky v reálném čase, které by jinak zabraly hodiny nebo dny výzkumu. Společnosti i pracovníci si uvědomili, že umělou inteligenci lze použít k urychlení práce snížením doby výzkumu.

Nevýhoda

Vzhledem k tomu všemu však některé aplikace AI mají nevýhodu. Primární nevýhodou AI je, že výsledky musí být stále stejné ověřeno.

I když je AI většinou správná, může poskytovat chybná nebo klamavá data, která mohou vést k chybným závěrům nebo výsledkům.

Softwaroví vývojáři a softwarové společnosti se vrhli na „kopiloty“ – specializované chatboty, kteří mohou vývojářům pomoci psát kód tím, že AI automaticky napíše náčrt funkcí nebo metod – což pak může vývojář ověřit.

I když je to velká úspora času, kopiloti mohou také napsat nesprávný kód. Microsoft, Amazon, GitHub a NVIDIA vydali kopiloty pro vývojáře.

Začínáme s chatboty

Abyste pochopili – alespoň na vysoké úrovni, jak chatboti fungují, musíte nejprve porozumět základům umělé inteligence, a to zejména strojovému učení (ML) a velkým jazykovým modelům (LLM).

Strojové učení je odvětví informatiky věnované výzkumu a vývoji pokusů naučit počítače učit se.

LLM je v podstatě program pro zpracování přirozeného jazyka (NLP), který ke generování textu využívá obrovské sady dat a neuronových sítí (NN). LLM fungují tak, že trénují kód AI na velkých datových modelech, které se z nich pak časem „učí“ – v podstatě se na základě přesnosti vstupních dat stávají doménovým expertem v určitém oboru.

Čím přesnější (a přesnější) vstupní data, tím přesnější a správnější bude chatbot, který model používá. LLM také spoléhají na Hluboké učení při školení na datových modelech.

Když chatbotovi položíte otázku, zeptá se svého LLM na nejvhodnější odpověď – na základě jeho učení a uložených znalostí o všech předmětech souvisejících s vaší otázkou.

Chatboti mají v podstatě předem vypočítané znalosti o tématu a za předpokladu dostatečně přesné LLM a dostatečného času na učení mohou poskytovat správné odpovědi mnohem rychleji, než to dokáže většina lidí.

Používání chatbota je jako mít okamžitě k dispozici automatizovaný tým PhD.

V lednu 2023 vydala Meta AI svůj vlastní LLM s názvem Lama. O měsíc později Google představil svého vlastního chatbota s umělou inteligencí, Bard, který je založen na vlastním LLM, LaMDA. Od té doby následovali další chatboti.

Generativní AI

V poslední době se některé LLM naučily, jak generovat netextová data, jako je grafika, hudba a dokonce celé knihy. Společnosti se zajímají o generativní umělou inteligenci, aby vytvořily věci, jako je firemní grafika, loga, názvy a dokonce i digitální filmové scény, které nahrazují herce.

Například obrázek miniatury pro tento článek vygenerovala umělá inteligence.

Jako vedlejší účinek generativní umělé inteligence se pracovníci začali obávat ztráty zaměstnání kvůli automatizaci řízené softwarem umělé inteligence.

Asistenti chatbotů

První komerční uživatelsky dostupný chatbot na světě (BeBot) byl vydán Bespoke Japan pro Tokyo Station City v roce 2019.

BeBot, vydaný jako aplikace pro iOS a Android, ví, jak vás nasměrovat na jakékoli místo v okolí stanice připomínající labyrint, pomůže vám uložit a vyzvednout zavazadla, poslat vás k informačnímu pultu nebo najít časy vlaků, pozemní dopravu nebo jídlo a obchody uvnitř nádraží.

Může vám dokonce říct, na která vlaková nástupiště se vydat pro nejrychlejší jízdu vlakem do libovolného místa ve městě podle délky cesty – to vše během několika sekund.

Chatovací aplikace MLC

The Kompilace strojového učení Projekt (MLC) je duchovním dítětem výzkumného pracovníka nadace Apache Deep Learning Siyuan Feng a Hongyi Jin a dalších se sídlem v Seattlu a v čínské Šanghaji.

Myšlenkou MLC je nasazení předkompilovaný LLM a chatboty pro spotřebitelská zařízení a webové prohlížeče. MLC využívá výkon spotřebitelských grafických procesorových jednotek (GPU) k urychlení výsledků a vyhledávání AI – díky tomu je AI na dosah většiny moderních spotřebitelských počítačových zařízení.

Další projekt MLC – Web LLM – přináší stejnou funkcionalitu do webových prohlížečů a je založen na jiném projektu – WebGPU. Web LLM podporuje pouze počítače se specifickými GPU, protože se spoléhá na kódové rámce, které tyto GPU podporují.

Většina asistentů umělé inteligence se spoléhá na model klient-server se servery, které vykonávají většinu těžké práce s umělou inteligencí, ale MLC zapéká LLM do místního kódu, který běží přímo na zařízení uživatele, čímž eliminuje potřebu serverů LLM.

Nastavení MLC

Chcete-li na svém zařízení spustit MLC, musí splňovat minimální požadavky uvedené na stránkách projektu a GitHubu.

Chcete-li jej spustit na iPhonu, budete potřebovat iPhone 14 Pro Max, iPhone 14 Pro nebo iPhone 12 Pro s alespoň 6 GB volné paměti RAM. K instalaci aplikace budete také muset nainstalovat aplikaci Apple TestFlight, ale instalace je omezena na prvních 9 000 uživatelů.

Zkoušeli jsme spustit MLC na základním iPadu 2021 se 64 GB úložiště, ale neinicializovalo se. Vaše výsledky se mohou na iPadu Pro lišit.

Můžete také vytvořit MLC ze zdrojů a spustit jej přímo v telefonu podle pokynů na stránce MLC-LLM GitHub. K načtení zdrojů budete potřebovat řídicí systém zdrojového kódu git na vašem Macu.

Chcete-li tak učinit, vytvořte novou složku ve Finderu na vašem Macu, použijte UNIX cd příkaz k navigaci k němu v Terminálu a poté spusťte git clone příkaz v Terminálu, jak je uvedeno na stránce MLC-LLM GitHub:

https://github.com/mlc-ai/mlc-llm.git a stiskněte Vrátit se. git stáhne všechny zdroje MLC do složky, kterou jste vytvořili.

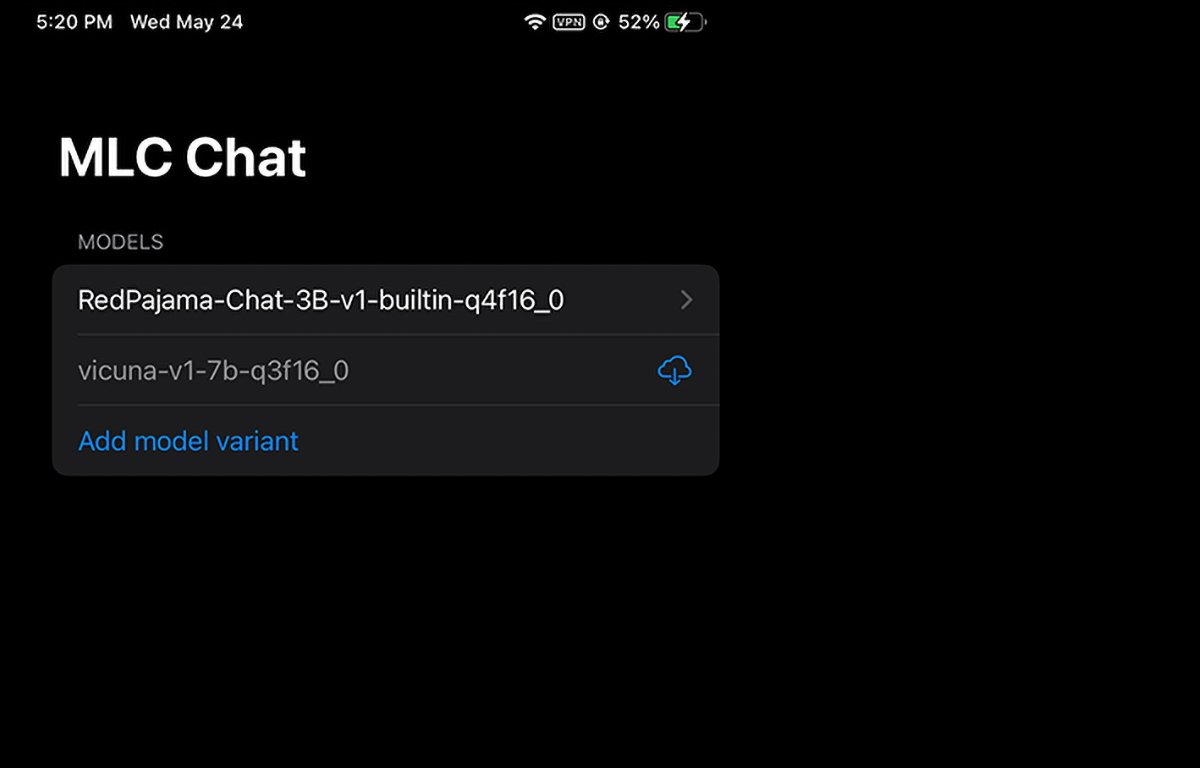

MLC běžící na iPhone. Můžete si vybrat nebo stáhnout, kterou modelovou hmotnost použít.

Předpoklady instalace pro Mac

U počítačů Mac a Linux se MLC spouští z rozhraní příkazového řádku v Terminálu. Chcete-li jej používat, musíte nejprve nainstalovat několik předpokladů:

- Správce balíčků Conda nebo Miniconda

- Homebrew

- Grafická knihovna Vulkan (pouze Linux nebo Windows)

- podpora velkých souborů git (LFS)

Pro uživatele GPU NVIDIA pokyny MLC konkrétně uvádějí, že musíte ručně nainstalovat ovladač Vulkan jako výchozí ovladač. Další grafická knihovna pro GPU NVIDIA – CUDA – nebude fungovat.

Uživatelé počítačů Mac mohou nainstalovat Miniconda pomocí správce balíčků Homebrew, o kterém jsme se již zmínili dříve. Všimněte si, že Miniconda je v konfliktu s jiným vzorcem Homebrew Conda, minikovárna.

Pokud tedy máte miniforge již nainstalovaný přes Homebrew, budete jej muset nejprve odinstalovat.

Podle pokynů na stránce MLC/LLM jsou zbývající kroky instalace přibližně:

- Vytvořte nové prostředí Conda

- Nainstalujte git a git LFS

- Nainstalujte si chatovací aplikaci příkazového řádku od Conda

- Vytvořte novou místní složku, stáhněte si váhy modelu LLM a nastavte proměnnou LOCAL_ID

- Stáhněte si knihovny MLC z GitHubu

To vše je podrobně uvedeno na stránce s pokyny, takže se zde nebudeme zabývat všemi aspekty nastavení. Zpočátku se to může zdát skličující, ale pokud máte základní dovednosti s terminálem macOS, je to opravdu jen pár jednoduchých kroků.

Krok LOCAL_ID pouze nastaví tuto proměnnou tak, aby ukazovala na jednu ze tří závaží modelu, které jste stáhli.

Hmotnosti modelů jsou staženy z komunitního webu HuggingFace, což je něco jako GitHub pro AI.

Jakmile je vše nainstalováno v Terminálu, můžete přistupovat k MLC v Terminálu pomocí mlc_chat_cli

Použití MLC ve webových prohlížečích

MLC má také webovou verzi Web LLM.

Varianta Web LLM běží pouze na počítačích Apple Silicon Mac. Neběží na počítačích Intel Mac a pokud to zkusíte, zobrazí se chyba v okně chatbota.

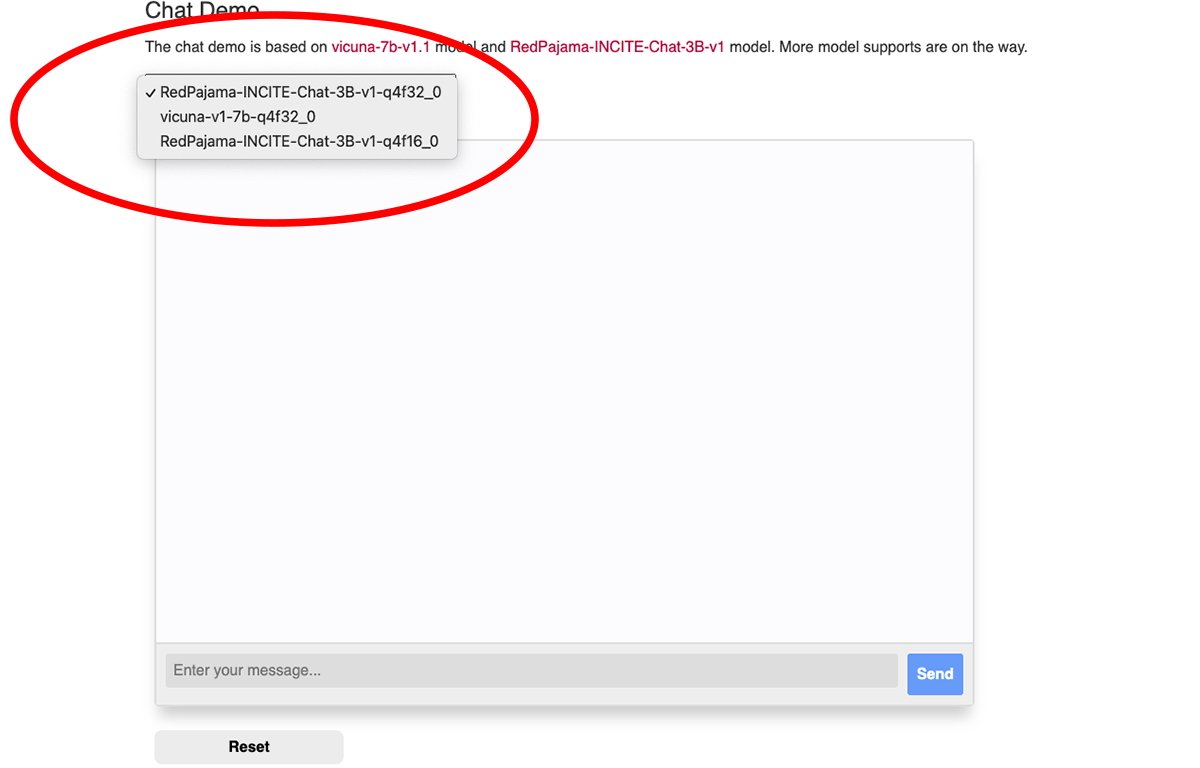

V horní části okna webového chatu MLC je vyskakovací nabídka, ze které si můžete vybrat, kterou váhu staženého modelu chcete použít:

Vyberte jednu z modelových hmotností.

K používání Web LLM (Chrome verze 113 nebo novější) budete potřebovat prohlížeč Google Chrome. Starší verze nebudou fungovat.

Číslo verze Chrome můžete zkontrolovat v nabídce Chrome ve verzi pro Mac na adrese Chrome->O Google Chrome. Pokud je k dispozici aktualizace, klepněte na Aktualizace tlačítko pro aktualizaci na nejnovější verzi.

Po aktualizaci možná budete muset Chrome restartovat.

Všimněte si, že stránka MLC Web LLM doporučuje spustit Chrome z terminálu Mac pomocí tohoto příkazu:

/Applications/Google\ Chrome.app/Contents/MacOS/Google\ Chrome — enable-dawn-features=allow_unsafe_apis,disable_robustness

allow_unsafe_apis‘ a disable_robustness‘ jsou dva příznaky spuštění prohlížeče Chrome, které umožňují používat experimentální funkce, které mohou, ale nemusí být nestabilní.

Jakmile je vše nastaveno, stačí zadat otázku do Zadejte zprávu pole ve spodní části podokna chatu webové stránky webové stránky LLM a klepněte na Poslat knoflík.

Éra skutečné umělé inteligence a inteligentních asistentů právě začíná. I když s AI existují rizika, tato technologie slibuje zlepšit naši budoucnost tím, že ušetří obrovské množství času a eliminuje spoustu práce.

Zdroj: appleinsider.com