Funkce detekce CSAM navržená společností Apple

I když byl kontroverzní plán Applu vypátrat materiál týkající se sexuálního zneužívání dětí pomocí skenování na iPhonu opuštěn, společnost má v úmyslu ho zastavit u zdroje.

Apple koncem roku 2021 oznámil dvě iniciativy, jejichž cílem bylo chránit děti před zneužíváním. Jedna, která je již v platnosti dnes, by varovala nezletilé před odesláním nebo přijetím fotografií s nahým obsahem. Funguje pomocí algoritmické detekce nahoty a pouze varuje děti – rodiče nejsou informováni.

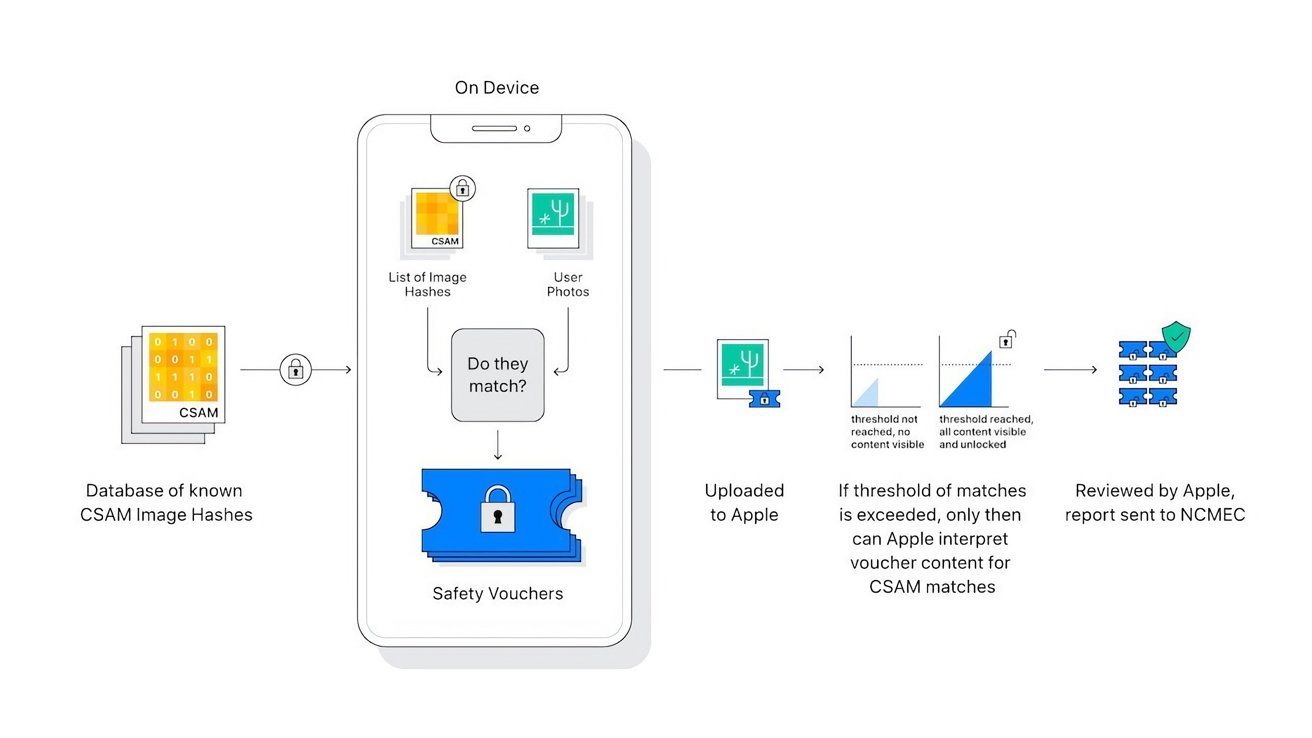

Druhá a mnohem kontroverznější funkce by analyzovala fotografie uživatele nahrávané na iCloud na iPhone uživatele, aby se zjistil známý obsah CSAM. Analýza byla provedena lokálně, na zařízení, pomocí hashovacího systému.

„Po rozsáhlých konzultacích s odborníky, abychom získali zpětnou vazbu o iniciativách na ochranu dětí, které jsme navrhli v loňském roce, prohlubujeme naši investici do funkce Communication Safety, kterou jsme poprvé zpřístupnili v prosinci 2021.“

„Dále jsme se rozhodli nepokročit s naším dříve navrhovaným nástrojem pro detekci sexuálního zneužívání dětí pro iCloud Photos. Děti mohou být chráněny, aniž by společnosti prohledávaly osobní údaje, a budeme pokračovat ve spolupráci s vládami, ochránci dětí a dalšími společnostmi, abychom pomohli chránit mladé lidi.“ , zachovat jejich právo na soukromí a učinit internet bezpečnějším místem pro děti i pro nás všechny.“

Prohlášení přichází chvíli poté, co Apple oznámil nové funkce, které by end-to-end šifrovaly ještě více dat na iCloudu, včetně obsahu a fotografií iMessage. Tyto posílené ochrany by znemožnily systém příznaků na straně serveru, který byl primární součástí detekce CSAM společnosti Apple.

Amazon, Google, Microsoft a další provádějí skenování na straně serveru jako zákonný požadavek, ale šifrování typu end-to-end v tom společnosti Apple zabrání.

Zdroj: appleinsider.com